生成AIの推論モデルの脅威

昨年(2024年)秋、OpenAIが、O1や現在のO3などの「推論モデル」を発表しました。それに続いてライバルのGoogle GeminiやClaude、中国のDeepSeekも、推論モデルを発表。

これらは大規模言語モデル(Large Language Model:LLM)に対し大規模推論モデル(Large Reasoning Model:LRM)と呼ばれています。

この推論モデル(LRM)によって、言葉の繋がりだけ(典型的な例が、「むかしむかし」の文章の後には「おじいさん~」という文章が続く)で、文章構築をする仕組みに過ぎないと言われていた生成AIが、人間にしかできない「推論」ができるようになったと言われました。

そしてご存じの通り、この推論の精度も日に日に上がっており、やがて人間をも超える、ASI(Artificial Super Intelligence:人工超知能)の出現、そしていわゆる「シンギュラリティ」も近いのでは・・という議論が巻き起こっています。

人工超知能は10年以内に出現する?

ASI(人口超知能)の出現は、いつなのか。例えばソフトバンクの孫正義社長は、2024年10月のSoftBank Worldのイベントで10年以内に起こると述べました。また今年の6月11日にはOpenAIのサム・アルトマンCEOが、「The Gentle Singularity(穏やかなシンギュラリティ)」というブログ記事で、やはり10年後の2035年にかけて、一気にというよりは”Gently”に超知能(超知性)を手にするだろうと述べています。

当然ながら、彼らはこれらの未来に対し「楽観的」ですが、昨年ノーベル物理学賞を受賞した「AIのゴッドファーザー」ジェフリー・ヒントン氏らは、AIの進歩は「人類の存続を脅かす」と警鐘を鳴らしています。

そのわかりやすいたとえが、ターミネーターの「スカイネット」でしょう。

現在のウクライナ紛争の主力兵器が、露ウ両国とも「自律型ドローン」となっていることを考えても、決して絵空事と笑い飛ばすことはできなそうです。

また、人間の知性や創造性をAIが「超える」ことで、仕事が奪われるばかりでなく、人間の「尊厳」が脅かされるかもしれない。

今私たちは、AIの進化に期待する気持ちと、仕事を奪われるなど、社会に取り残されたり、自分の尊厳を脅かされる気持ちなどの不安感の両方を持っているのではないでしょうか。

本当にASIは出現するのか?否定論も

ただ、このような議論は、そもそも今の生成AIの進化の延長に「人間を超えるASIが出現する」というのが前提にあります。

ヒントン氏と並ぶ、AI開発の第一人者のヤン・ルカン氏(メタ(Facebook)チーフAIサイエンティスト)は、6月15日の日経新聞のインタビュー記事で、「ジェフ(ヒントン)は、膨大なデータをAIに学ばせる大規模言語モデル(LLM)に基づく知能の進化を過大評価している」「LLMに大量のデータを学ばせ続ければ人間並みの知能に達するという考えは間違っている。LLMは既存のデータを基に正解の確率が高い回答を導き出すものだ。あらかじめ学んだ状況にしか対処できず、人間のように未知の課題に対して解決策を考えだすことはできない」と述べています。

私も拙書「いつもひらめいている人の頭の中」(幻冬舎新書)の中で、「AIは決してひらめかない」と書きました。AIは人間の持つ知識の最先端に到達することはできるが、その先、つまり人間を超えることはできない。その人間の能力こそが「ひらめき」であるというのがその趣旨で、これは「だれもが持っている能力である」というのが、この本の中で主張したいことでした。

ただ、この手の議論は得てして信念や思想など「哲学論争」になりがちです。現実の「技術論」として、AIや生成AIはその技術特性として、どこまでできて限界はどこなのか、私たちはそれを知ったうえで考える必要があるのではないでしょうか。

複雑な問題に対応できないAIシステム

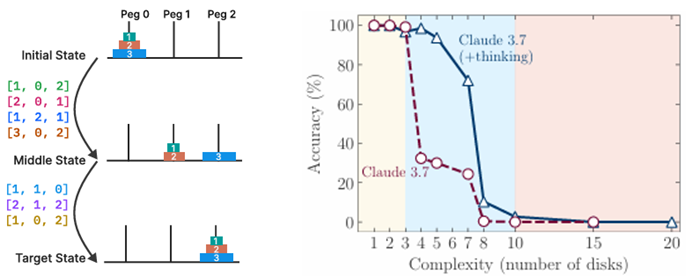

AppleのAI研究者によって最近発表された「The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity」(思考の幻想:問題の複雑性というレンズを通した推論モデルの長所と限界への理解)という論文で、技術者たちは、今までAIの性能のベンチマークだった「一流大学の入試問題」「プログラミング問題」ではなく「ハノイの塔」や「川渡り問題」というパズルの問題を解かせました。

それで判ったことは、ある程度複雑な問題なら「大規模推論エンジン(LRM)」は解くことができますが、その複雑さがある一定の閾値を超えると、「全く役に立たない」ことでした。

ディスクを隣の棒に移す「ハノイの塔」では、下図のグラフのようにディスクの数が8枚を超えるとLRMの推論は「崩壊」します。ちなみにこれは、慣れれば子供でも溶ける問題ですし、その解答方法も様々なネットで参照することが可能にもかかわらずです。

社会課題の解決の世界、つまりデザイン思考やシステム思考の世界では、こういう複雑さを増した問題、いわゆる「厄介な問題(Wicked Problems)」にどう対処するかというのが、数十年以上も前からリチャード・ブキャナンやホースト・リッテルらによって指摘されてきました。

関連記事:デザイン思考の歴史

複雑な問題の典型的な例が、身近な人間関係の問題ですね。もう少し範囲を拡大すると家族や職場、地域や国家といった「社会システム」の問題が該当するでしょう。

これらの問題解決手法は、「論理的思考」に代表される「要素還元思考」では解けません。いわゆる「創造的思考」が必要なのは、当サイトでも折に触れ指摘している通りです。

そして1990年代以降の創造的思考を代表する「デザイン思考」「システム思考」のブームの中で、様々な手法(例えば因果ループ図など)が提案されてきました。

一方の生成AIの推論手法というのは、SoftBank Worldの孫さんの講演でも述べられていましたが、これはChain of Thought(COT)というプロンプト技法がベースになっています。

当サイトでも2年前の記事で解説していますので、興味のある方はご覧いただければと思います。

関連記事:ChatGPTのCOT(Chain of Thought)とTOT(Tree of Thoughts)プロンプトの解説

確かにCOTによる、複雑な(complicated)な問題を分解して課題解決に導く方法は、要素還元手法として知られ、特に「論理的思考問題」にはその力を発揮します。

そしてほとんどの「学問」は、その分野に属しますので、生成AIがその分野で人間を上回るのは当然かもしれません。

しかしデザイン思考やシステム思考に代表される「要素還元では解けない複雑(Complex)な問題」、すなわち「創造的問題」は、生成AIで解くのが難しい問題であるのがわかります。

もちろんこういった複雑な問題(Wicked Problems)は生成AIばかりでなく、人間自身にとっても解くのが難しい問題です。私たちにも「思考の限界」があり、ハーバート・サイモンが指摘したように、あらゆる情報を加味して合理的に考えるのは人間にとって難しい(限定合理性)のに加え、「教育」で学ぶのは「要素還元思考」「論理的思考」で、こういう思考術が優れている人が、「優秀」とされ、社会の第一線で活躍してきたという認識があります。

こういう時代だからこそ、創造的問題を解く「ひらめき」「創造性」が、人間にとって何より重要になってくる「力」「特性」ではないかと考えます。